Nginx: El Secreto de su Rendimiento y su Rol Esencial en Docker y Kubernetes

Una guía completa para desarrolladores. Descubre cómo la arquitectura master-worker y el event loop de Nginx le permiten manejar millones de conexiones, y aprende a usarlo como reverse proxy en Docker y como Ingress Controller en Kubernetes.

June 11, 2025

Joan Sebastian Oviedo

Ingeniero Informático

Nginx: El Secreto de su Rendimiento y su Rol Esencial en Docker y Kubernetes

Si trabajas en desarrollo web, es casi imposible no haber oído hablar de Nginx (pronunciado "engine-ex"). Es una de las piezas de software más desplegadas en internet, actuando como el pilar silencioso detrás de gigantes como Netflix, WordPress.com y muchos más. Pero, ¿qué lo hace tan especial? ¿Cómo es posible que un solo servidor con Nginx pueda manejar cientos de miles, o incluso un millón, de conexiones simultáneas?

Este artículo desglosa la brillante arquitectura de Nginx, basándonos en sus principios clave, y te mostrará cómo puedes y debes usarlo en tus flujos de trabajo modernos con Docker y Kubernetes.

El Motor de Nginx: Cómo Soporta Millones de Conexiones

La magia de Nginx no reside en un truco, sino en un diseño fundamentalmente diferente al de servidores más antiguos como Apache. En lugar de crear un hilo (thread) o proceso por cada conexión —un método que se agota rápidamente—, Nginx utiliza un modelo mucho más inteligente y escalable.

1. La Arquitectura Master-Worker

El diseño de Nginx se basa en un proceso maestro (master) y varios procesos trabajadores (workers).

- El Proceso Maestro: Su única misión es leer y validar el archivo de configuración, y gestionar los procesos trabajadores. Se ejecuta como root para poder abrir puertos privilegiados (como el 80 y 443), pero no hace ningún trabajo de red real. Si necesitas recargar la configuración, se lo dices al maestro y él se encarga de hacerlo elegantemente sin desconectar a ningún cliente.

- Los Procesos Trabajadores: Estos son los que hacen el trabajo pesado. Cada trabajador es un proceso de un solo hilo (single-threaded) que maneja miles de conexiones de clientes simultáneamente.

2. El Event Loop Asíncrono y No Bloqueante

Aquí está el verdadero secreto. En lugar de esperar a que una petición termine para procesar la siguiente, cada trabajador opera con un event loop. Imagina un mesero increíblemente eficiente en un restaurante gigante:

- Toma la orden de la mesa 1 (inicia una petición de red).

- En lugar de esperar en la cocina, inmediatamente va a la mesa 2 y toma su orden (inicia otra petición).

- Luego a la mesa 3, y así sucesivamente.

- Cuando la cocina le avisa que un plato está listo (el evento de "datos recibidos" ocurre), lo recoge y lo lleva a la mesa correspondiente.

Este modelo, conocido como E/S (Entrada/Salida) asíncrona y no bloquante, permite a un solo proceso trabajador gestionar miles de conexiones sin estar nunca inactivo. Utiliza mecanismos del sistema operativo como epoll (en Linux) o kqueue (en FreeBSD) para ser notificado de nuevos eventos de red de manera muy eficiente.

3. Aislamiento y Eficiencia de CPU

Para maximizar el rendimiento, la configuración típica es ejecutar un proceso trabajador por cada núcleo de CPU. Puedes "fijar" cada trabajador a un núcleo específico. Esto evita que el sistema operativo mueva los procesos entre núcleos, lo que mejora el uso de la caché de la CPU y reduce el cambio de contexto, exprimiendo hasta la última gota de rendimiento.

4. Manejo de Tareas Bloqueantes y Estado Compartido

- ¿Y si algo tarda mucho, como leer un archivo grande del disco? Nginx es lo suficientemente inteligente como para delegar estas tareas potencialmente bloquantes a un conjunto de hilos (thread pool) separado, manteniendo el event loop principal libre para seguir atendiendo peticiones.

- ¿Cómo comparten información los workers? Para funcionalidades como el cacheo de datos o el límite de peticiones (rate limiting), Nginx configura zonas de memoria compartida (shared memory) que todos los trabajadores pueden leer y escribir de forma segura.

Nginx en el Mundo Moderno: Docker y Kubernetes

Entender su arquitectura es clave, pero su poder hoy en día se magnifica por cómo se integra en contenedores.

Nginx con Docker: El Compañero Perfecto

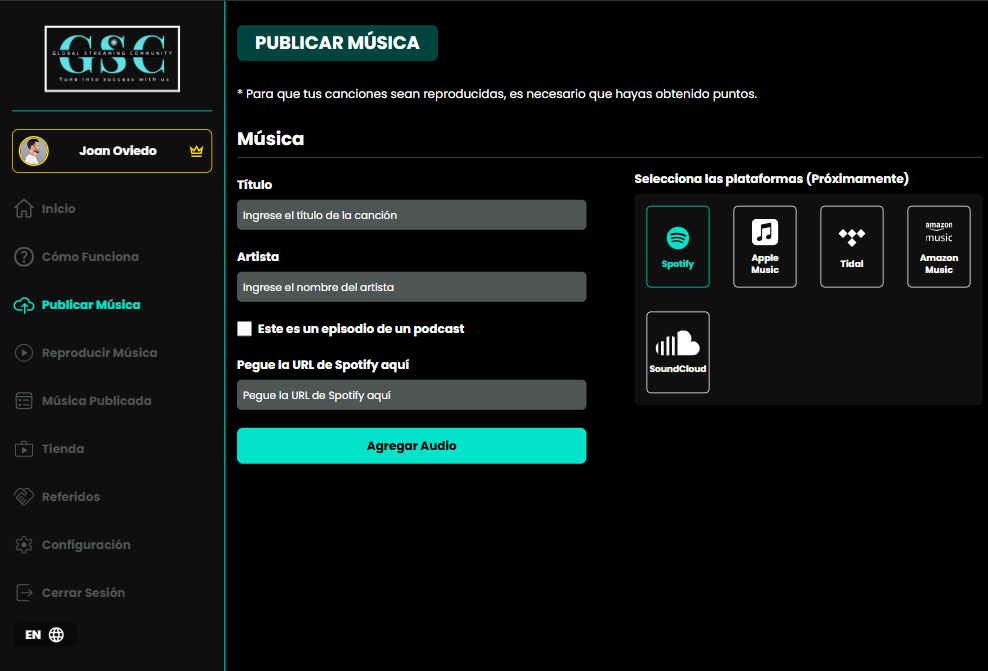

En Docker, Nginx es una herramienta ligera y versátil. El caso de uso más común es como Reverse Proxy.

Imagina que tienes una aplicación en Node.js, Python o Java ejecutándose en un contenedor. No quieres exponerla directamente a internet. En su lugar, colocas un contenedor de Nginx delante:

Nginx escucha en los puertos 80/443.

Recibe todo el tráfico entrante.

Terminación SSL: Maneja todo el cifrado HTTPS, liberando a tu aplicación de esa tarea.

Servir Archivos Estáticos: Puede servir directamente el frontend (React, Vue, Angular) y otros archivos estáticos (CSS, imágenes) de forma ultrarrápida.

Proxy Inverso: Redirige las peticiones de API (ej. /api/*) al contenedor de tu aplicación.

Ejemplo: Un desarrollador frontend puede crear una aplicación React y empaquetarla en una imagen de Nginx con una configuración simple para servir los archivos estáticos del build, sin necesidad de un servidor Node.js complejo solo para eso.

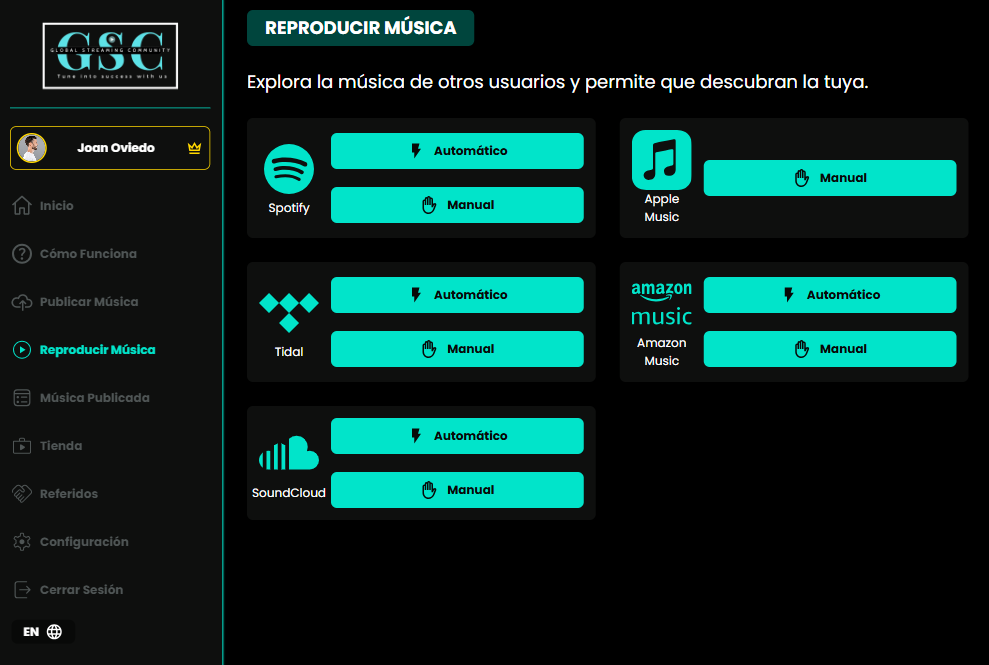

Nginx en Kubernetes: El Controlador de Tráfico

En Kubernetes, el rol de Nginx se eleva. Aquí, brilla como el Ingress Controller más popular del mundo.

- ¿Qué es un Ingress? En Kubernetes, tus aplicaciones se ejecutan como servicios dentro de un clúster, con IPs internas. Un recurso Ingress es una regla que define cómo el tráfico externo (de internet) debe llegar a esos servicios internos.

- ¿Qué es un Ingress Controller? Es el Nginx (u otro proxy) que realmente implementa esas reglas. Es un pod de Nginx con superpoderes que observa la API de Kubernetes. Cuando creas una regla de Ingress como "el tráfico para miapi.com/usuarios debe ir al servicio servicio-usuarios", el Nginx Ingress Controller lo detecta y actualiza su propia configuración en tiempo real para empezar a redirigir el tráfico correctamente.

En resumen, en Kubernetes, Nginx actúa como la puerta de entrada inteligente y configurable para todo tu clúster.

Conclusión: ¿Por Qué Debes Usar Nginx?

Nginx es mucho más que un simple servidor web. Es una navaja suiza para el tráfico de red, diseñada desde cero para un rendimiento y una eficiencia extremos.

- Para un desarrollador backend: Es la forma estándar de exponer tu aplicación de forma segura, manejar SSL y balancear la carga entre múltiples instancias.

- Para un desarrollador frontend: Es la manera más simple y de mayor rendimiento para desplegar tu aplicación estática.

- Para un ingeniero de DevOps/Plataforma: Es la herramienta por defecto para gestionar el enrutamiento de tráfico en arquitecturas complejas como Kubernetes.

Entender sus principios de diseño no solo te ayuda a configurarlo mejor, sino que te enseña lecciones valiosas sobre cómo construir sistemas escalables y de alto rendimiento.